近期,人工智能领域迎来了一项引人注目的新突破。据上周五发布的一项研究报告显示,斯坦福大学与华盛顿大学的科研人员成功以不到50美元(当前汇率约364元人民币)的云计算成本,训练出了一个具备强大“推理”能力的人工智能模型。

这款名为s1的模型,在数学与编程能力测试中,展现出了与OpenAI的o1及DeepSeek的r1等顶尖推理模型相当的水平。尤为s1模型及其训练所用的全部数据和代码,均已在GitHub平台上实现开源,供全球开发者学习与参考。

s1团队透露,他们采用了“蒸馏”技术来构建这一模型。该技术通过让新模型学习另一已有模型的答案,从而提炼出推理能力。具体而言,s1是从谷歌的推理模型Gemini 2.0 Flash Thinking Experimental中蒸馏而来。有趣的是,就在上个月,加州大学伯克利分校的研究人员也采用了相同的蒸馏方法,不过他们的成本约为450美元。

s1模型的出现,无疑引发了业界对于人工智能模型商品化的深刻思考。当个人或小型团队能够以极低的成本复制出价值数百万美元的模型时,大型科技公司的竞争优势何在?这一话题引发了广泛讨论。

面对这一挑战,大型人工智能实验室表达了不满。例如,OpenAI就曾指责DeepSeek不当获取其API数据用于模型蒸馏。s1团队则希望探索实现高效推理性能和“测试时扩展”的最简化路径,这些正是OpenAI的o1模型所展现出的突破点。

s1的论文详细阐述了监督微调(SFT)方法在蒸馏推理模型中的应用。与DeepSeek采用的大规模强化学习方法相比,SFT方法更具成本效益。它通过使用相对较小的数据集,明确指示模型在数据集中模仿特定行为,从而实现了高效的模型训练。

值得注意的是,谷歌通过其Google AI Studio平台免费提供了Gemini 2.0 Flash Thinking Experimental模型的访问权限,但设有每日使用限制。然而,其使用条款明确禁止对模型进行逆向工程,以开发与谷歌自身人工智能产品竞争的服务。尽管如此,s1团队还是巧妙地利用了这一资源。

s1模型基于阿里巴巴旗下中国人工智能实验室Qwen提供的一款小型、现成的免费人工智能模型。为了训练s1,研究人员精心策划了一个包含1000个问题及其答案的数据集,并加入了谷歌Gemini 2.0 Flash Thinking Experimental为每个答案提供的“思考”过程。他们利用16个Nvidia H100 GPU,在不到30分钟的时间内完成了模型训练,成本仅为约20美元。

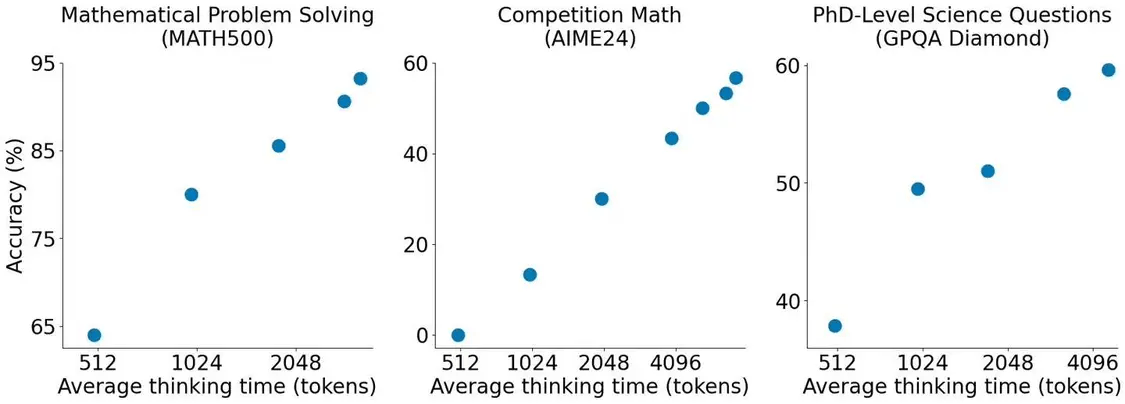

s1团队还采用了一个独特的技巧来提升模型的准确性和“思考”时间:他们让模型在推理过程中“等待”。论文显示,这一简单的添加有助于模型得出更为准确的答案。