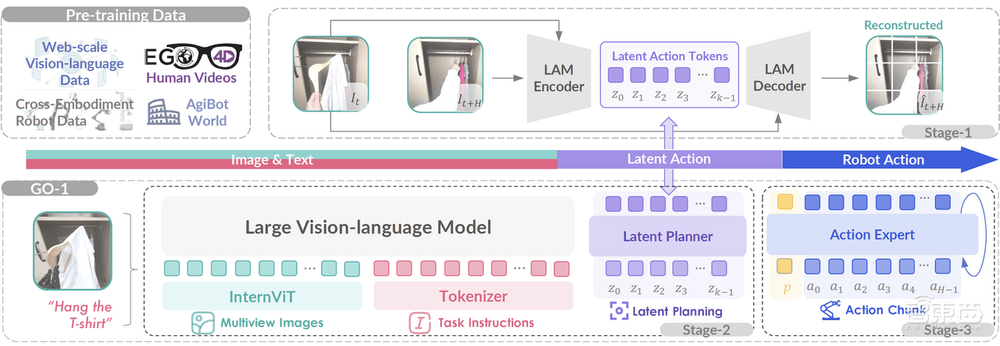

近日,智元机器人在科技领域迈出了重要一步,正式推出了其首个通用具身基座模型——Genie Operator-1(简称GO-1)。这款模型采用了创新的Vision-Language-Latent-Action(ViLLA)框架,融合了VLM(多模态大模型)与MoE(混合专家)技术,为机器人的智能化发展开辟了新路径。

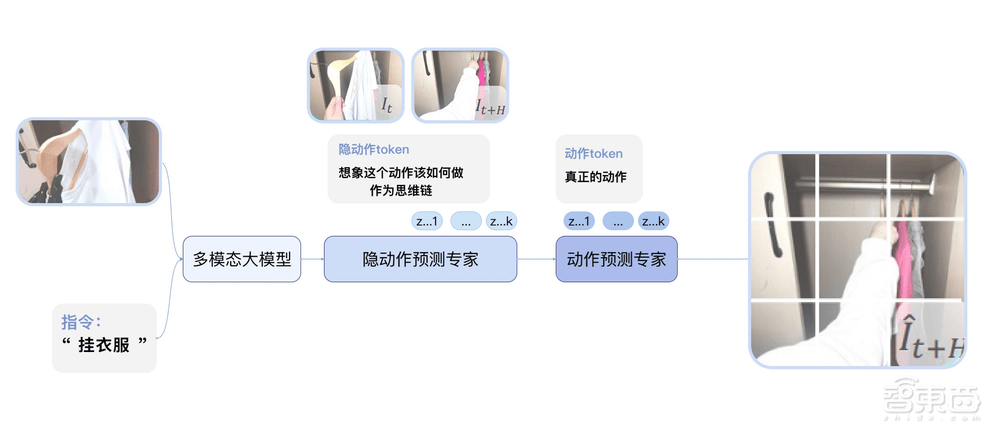

GO-1的核心竞争力在于其小样本快速泛化能力,以及“一脑多形”的跨本体应用特性。VLM作为模型的主干网络,继承了开源多模态大模型的权重,并通过互联网大规模纯文本和图文数据的训练,赋予了GO-1强大的场景感知和理解能力。而MoE中的隐动作专家模型和动作专家模型,则分别利用互联网上的大规模人类操作和跨本体操作视频,以及高质量的仿真数据和真机数据,进一步提升了模型的动作理解和执行能力。

在具体应用上,GO-1展现出了极高的灵活性和适应性。用户只需通过简单的语言指令,就能让机器人完成各种复杂的任务。例如,在家庭中,机器人可以帮忙准备餐食、收拾桌面;在办公和商业场景中,机器人则能接待访客、发放物品等。GO-1还能快速适应不同的机器人形态,实现跨本体的部署和应用。

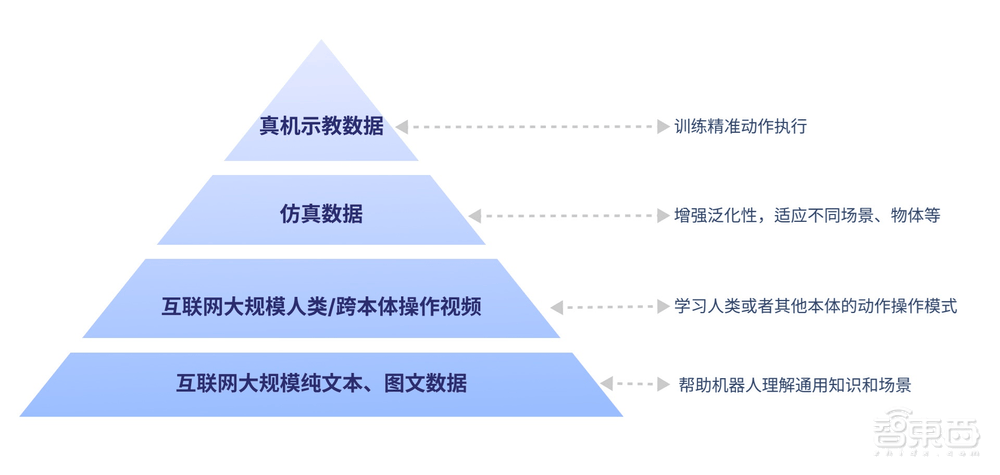

GO-1的成功,离不开其背后强大的数字金字塔架构。该架构以互联网的大规模纯文本与图文数据为底层,之上是互联网的大规模人类操作/跨本体视频,再上层是仿真数据,用于增强泛化性。而金字塔的顶层,则是高质量的真机示教数据,用于训练精准动作执行。这种架构使得GO-1能够接受全面的“基础教育”和“能力培训”,从而轻松应对多种多样的环境和物体,快速学习新的操作。

GO-1所采用的ViLLA框架,在Vision-Language-Action(VLA)模型的基础上进行了创新。通过预测Latent Action Tokens(隐式动作标记),ViLLA框架成功弥合了图像-文本输入与机器人执行动作之间的鸿沟。这意味着,当用户用平常讲话的方式告诉机器人要做的事情时,模型能够准确理解用户的意图,并拆解成具体的步骤来执行。

在实际应用中,GO-1展现出了惊人的表现。无论是准备早餐、倒水烤吐司,还是在商务会议中帮忙拿饮料、苹果,GO-1都能迅速响应并完成任务。GO-1还具备持续进化的能力。当机器人遇到问题时,如做咖啡时杯子放歪等,GO-1能通过数据回流系统持续学习,不断优化自身的行为模式,直到成功完成任务。

智元机器人的GO-1,无疑为具身智能的发展树立了新的标杆。它不仅解决了具身智能在场景和物体泛化能力不足、语言理解能力欠缺、新技能学习缓慢以及跨本体部署困难等方面的问题,更为机器人走向更多不同场景、适应多变的真实世界提供了强大的脑力支持。随着技术的不断进步和应用场景的不断拓展,GO-1有望成为未来机器人领域的重要力量。