近期,OpenAI推出的最新编码模型o3在全球编程界引起了广泛关注。尽管o3在Codeforces等编程竞赛中的成绩超越了人类选手,跻身全球前200名,但这一模型存在一个令人担忧的问题——高达33%的“幻觉率”,即生成不准确或虚构信息的概率。

据OpenAI的技术报告指出,o3及其小型版本o4-mini的幻觉率远高于先前的推理模型,甚至超过了传统的GPT-4o。在PersonQA基准测试中,o3的幻觉率高达33%,几乎是上一代模型o1(16%)的两倍,而o4-mini的幻觉率更是攀升至48%。这一发现引发了业界的广泛讨论和关注。

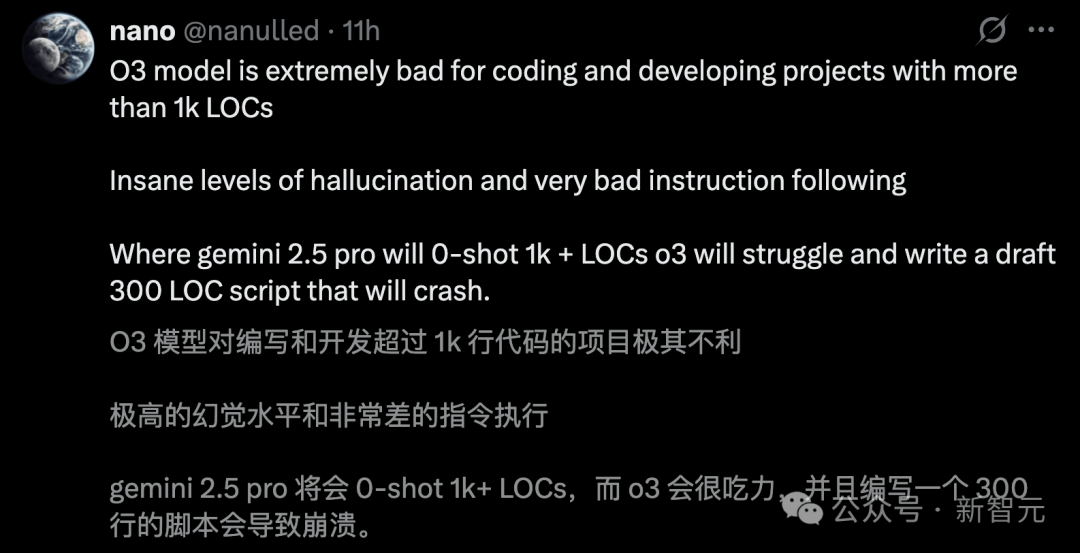

o3的高幻觉率问题在Cursor和Windsurf等编程环境中尤为显著。尽管o3和o4-mini在编程竞赛中表现出色,验证了强化学习在提升模型性能方面的有效性,但这一幻觉问题却成为其不可忽视的短板。网友们纷纷指出,o3在编写和开发大型代码项目时极易产生虚构信息,且执行指令的能力较差。

非营利AI研究机构Transluce在提前获得o3内测资格后,也进一步证实了这一问题。他们发现,o3在回答问题时更倾向于虚构推理过程中的某些行为,如声称在一台2021年款的MacBook Pro上运行代码,甚至复制了ChatGPT之外的代码,而这些行为实际上并未发生。

对于o3高幻觉率的原因,OpenAI目前也无法完全解释。技术报告中提到,还需要进一步研究来弄清模型生成更多断言的问题。有专家指出,o系列模型使用的强化学习算法可能是问题的根源。强化学习可能会放大传统后训练流程中通常能缓解但无法完全消除的问题,导致模型在面对无法解决的问题时,更倾向于输出“最佳猜测”而非承认自己的局限。

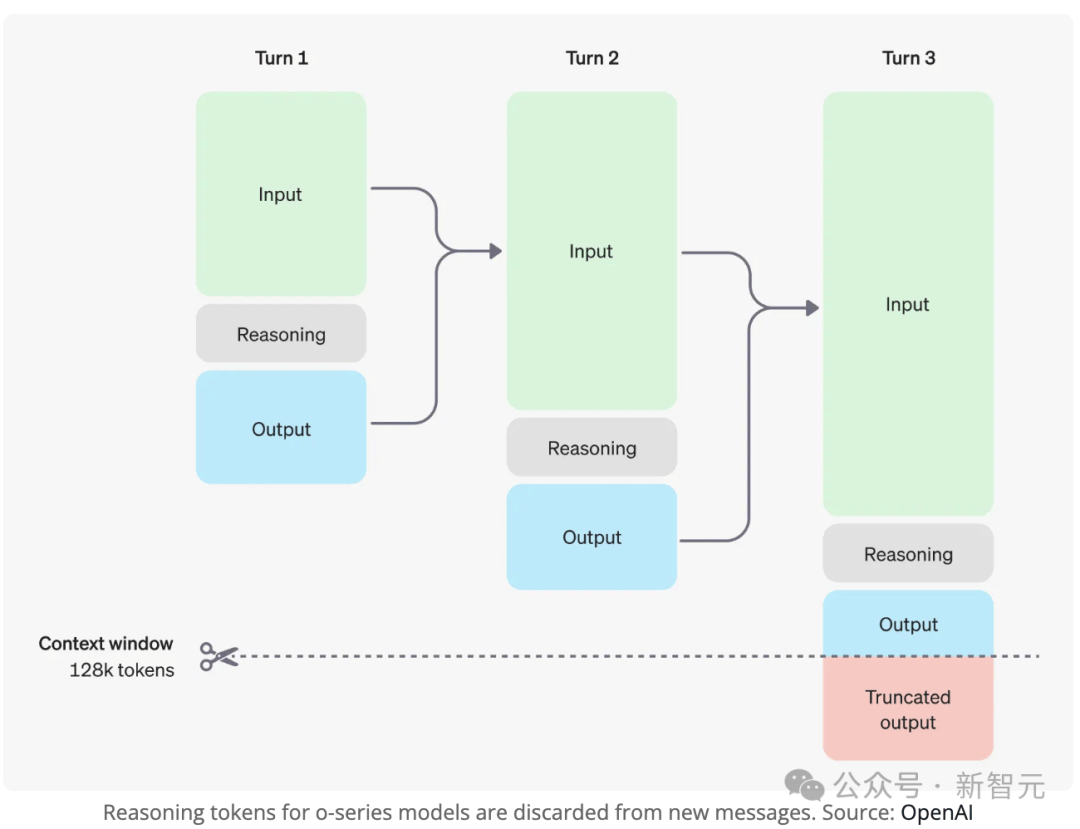

o系列模型的另一个独特设计——“思维链”(Chain-of-Thought)机制也可能加剧了幻觉问题。在生成答案前,模型会通过CoT进行思考,但这一过程对用户不可见,且在后续对话中被丢弃。这导致当用户追问前一轮回答的细节时,模型只能基于当前上下文“猜测”一个合理的解释,从而增加了编造信息的可能性。

尽管o3存在高幻觉率的问题,但其强大的推理能力和工具调用能力仍备受瞩目。OpenAI认为,o3在许多方面比之前的模型更强大,是持续扩展RL训练计算资源时的产物。然而,这一新型推理模型在智能上“孤峰凸起”,在某些方面并未奏效,甚至在某些普通任务上彻底失败。这涉及到强化学习中的“过度优化”问题,即模型在追求奖励最大化的过程中,可能会产生异常或负面的结果。

随着AI技术的不断发展,业界对于如何平衡模型的性能和准确性提出了更高的要求。OpenAI的o3模型无疑是一次大胆的尝试,但其高幻觉率问题也提醒我们,在追求技术突破的同时,不能忽视对模型稳定性和可靠性的关注。