腾讯技术团队近期对DeepSeek开源的DeepEP通信框架实施了深度优化策略,此举显著提升了该框架在多种复杂网络环境下的性能表现。

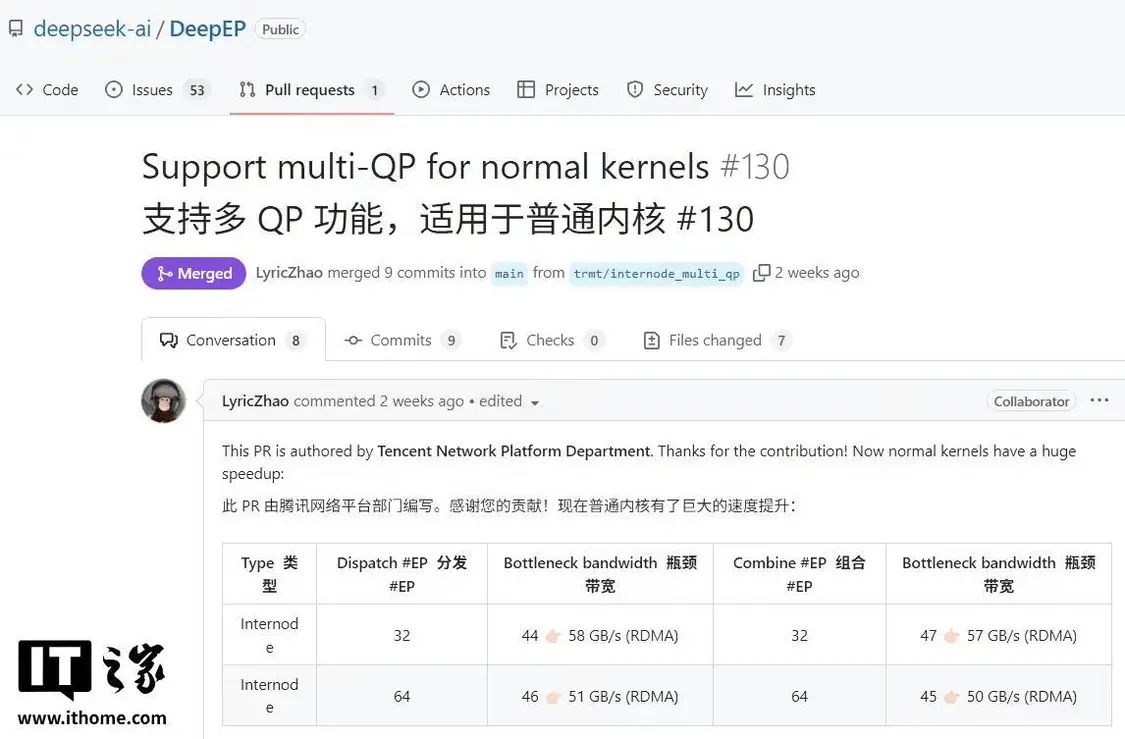

经过严格测试,优化后的DeepEP通信框架在RoCE网络环境中实现了性能翻倍的壮举,同时在IB(InfiniBand)网络环境下也取得了30%的性能提升。这一突破性进展为企业在AI大模型训练领域提供了更为高效的解决方案。

DeepEP通信库专为专家混合(MoE)和专家并行(EP)设计,旨在提供高吞吐量和低延迟的全对全GPU内核通信能力,这些内核被广泛应用于MoE的派发和组合操作。该库还支持低精度运算,包括FP8格式,进一步拓宽了其应用场景。

腾讯星脉网络团队在DeepEP开源后迅速投入研发,针对双端口网卡带宽利用率不足以及CPU控制面交互时延两大关键瓶颈展开了技术攻关。经过不懈努力,团队成功突破了这些技术障碍。

在腾讯的技术优化下,DeepEP在RoCE网络环境中的性能实现了质的飞跃,同时在IB网络环境中也展现出了更加出色的通信效率。这一优化成果不仅提升了DeepEP的竞争力,更为腾讯自身的AI大模型训练项目如混元大模型等提供了强有力的支持。

该技术已经全面开源,并在腾讯星脉与H20服务器构建的环境中得到了成功应用。实践证明,该方案在训练推理过程中展现出了出色的通用性和稳定性,为AI大模型训练领域注入了新的活力。