阿里通义近日发布全新基础模型架构Qwen3-Next,同步开源Qwen3-Next-80B-A3B系列模型。该架构通过创新设计,在总参数800亿规模中仅激活30亿参数,即可达到千亿参数模型Qwen3-235B的性能水平,实现计算效率的革命性突破。实验数据显示,新模型训练成本较Qwen3-32B降低超90%,长文本处理吞吐量提升10倍以上,为大模型训练与推理树立全新效率标杆。

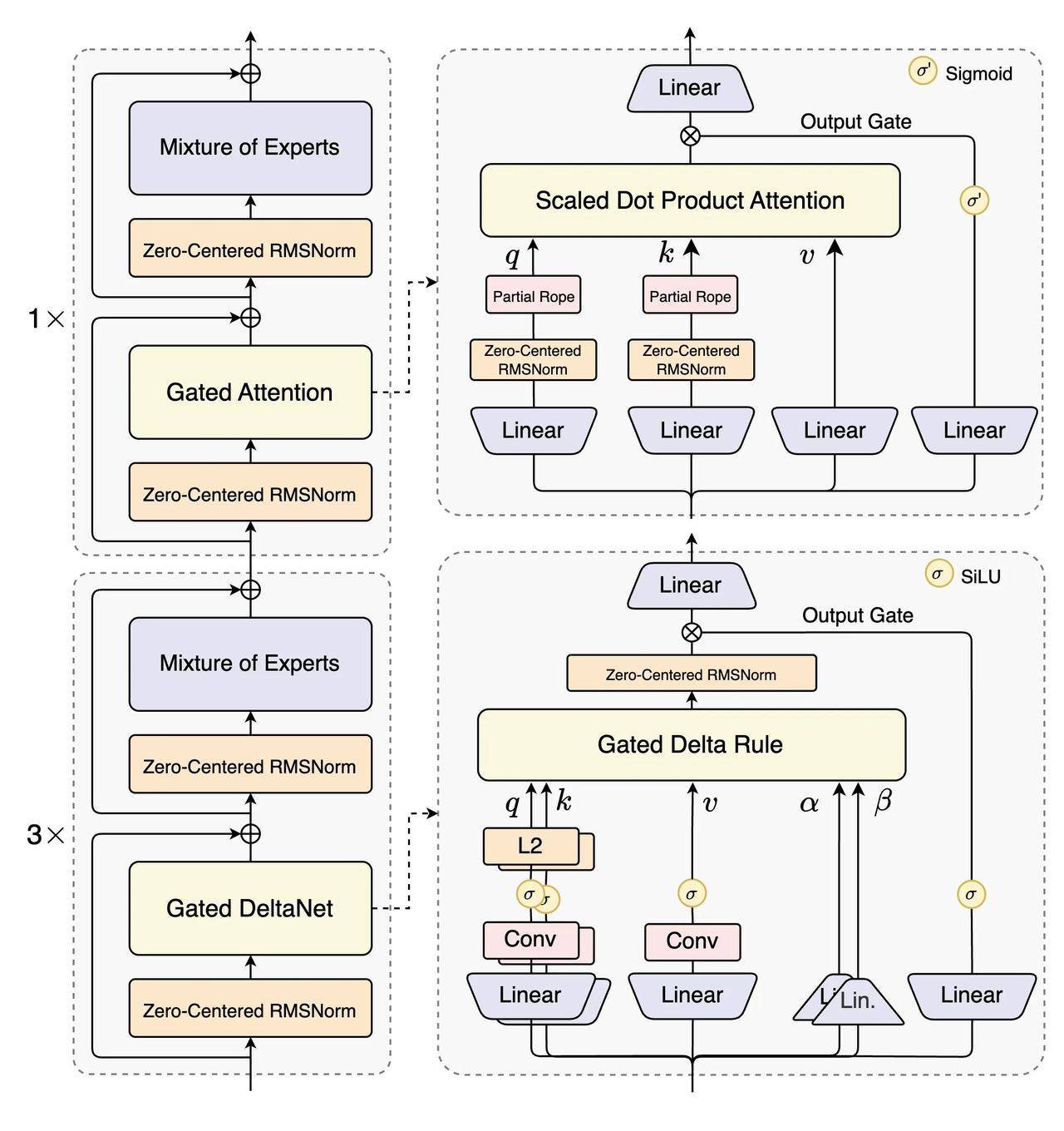

针对大模型参数规模与上下文长度持续扩展的趋势,Qwen3-Next在架构层面进行多项突破性改进。相较于4月发布的Qwen3 MoE模型,新架构引入混合注意力机制、超高稀疏度MoE结构、训练稳定性优化方案及多token预测(MTP)技术。其中,高稀疏MoE架构将专家激活比例从1:16压缩至1:50,创下行业新纪录。这种设计使模型在保持高性能的同时,显著降低计算资源消耗。

在模型训练方面,通义团队采用分阶段优化策略。基础模型Qwen3-Next-Base在15万亿token的子数据集上完成预训练,仅消耗Qwen3-32B模型9.3%的GPU资源,却实现更优性能。后续通过强化学习训练攻克稳定性与效率平衡难题,推动模型综合能力实现质的飞跃。测试结果显示,指令模型Qwen3-Next-Instruct在编程(LiveCodeBench v6)、人类偏好对齐(Arena-Hard v2)等任务中超越旗舰模型Qwen3-235B,在通用知识(SuperGPQA)、数学推理(AIME25)等核心能力上全面领先Qwen3-32B。

推理模型Qwen3-Next-Thinking的表现同样亮眼,在数学推理AIME25评测中取得87.8分的优异成绩,全面超越Gemini2.5-Flash-Thinking。值得关注的是,这些突破性性能的达成,仅需激活模型总参数的3.75%。这种"小参数、大能力"的特性,为大规模商业应用提供了更具性价比的技术方案。

在长文本处理能力建设上,Qwen3-Next对Transformer核心组件进行重构。通过融合Gated DeltaNet线性注意力与自研门控注意力机制,新架构在保持内存效率的同时,将计算复杂度降至传统方法的1/5。配合预训练阶段引入的多token预测技术,模型在处理超32K tokens长文本时,推理速度较Qwen3-32B提升10倍以上,为处理复杂任务奠定技术基础。

近期阿里通义在模型研发领域持续发力,相继推出万亿参数Qwen3-Max-Preview、文生图编辑模型Qwen-Image-edit、语音识别模型Qwen3-ASR-Flash等产品,并深化"全尺寸、全模态"开源战略。据全球最大AI开源社区HuggingFace统计,基于通义千问Qwen的衍生模型已超过17万个,稳居全球开源模型榜首。市场调研机构沙利文报告显示,2025年上半年中国企业级大模型调用市场中,阿里通义以17.7%的占比领跑行业。