近期,人工智能领域迎来了一场震撼发布,埃隆·马斯克旗下的人工智能初创公司xAI推出了其最新力作——Grok 3大模型。马斯克在发布会上毫不吝啬地赞誉其为“地球上最聪明的人工智能”,这一声明迅速引发了业界的广泛关注与讨论。

据官方公布的测试结果,Grok 3在多项基准测试中表现抢眼,尤其是在AIME(数学能力评估)和GPQA(博士级物理学、生物学、化学问题评估)等关键领域,其成绩远超GPT-4o、Gemini-2 Pro、DeepSeek V3、Claude 3.5及Sonnet等大模型。在备受瞩目的大模型竞技场Chatbot Arena(LMSYS)测试中,早期版本的Grok 3更是以140分的优异成绩夺得榜首,将Gemini 2.0 Flash Thinking实验版、ChatGPT-4o最新版本及DeepSeek R1等强劲对手甩在身后。

然而,尽管官方数据亮眼,部分用户在亲身体验后却对Grok 3的实际能力产生了质疑。他们认为,Grok 3的表现并未达到马斯克所宣称的高度。更为戏剧性的是,OpenAI应用研究主管Boris Power公开表达了对Grok团队评估方法的失望,指责其存在作弊嫌疑,并强调o3-mini在各项评估中的表现均优于Grok 3。

为了探究真相,《每日经济新闻》记者亲自对Grok 3进行了深入测试。测试发现,Grok 3确实展现出了世界顶级AI模型的水平,但在与其他模型的对比中并未形成明显的优势。其最突出的特点在于极快的响应速度,这一点远超其他同等级的大模型。

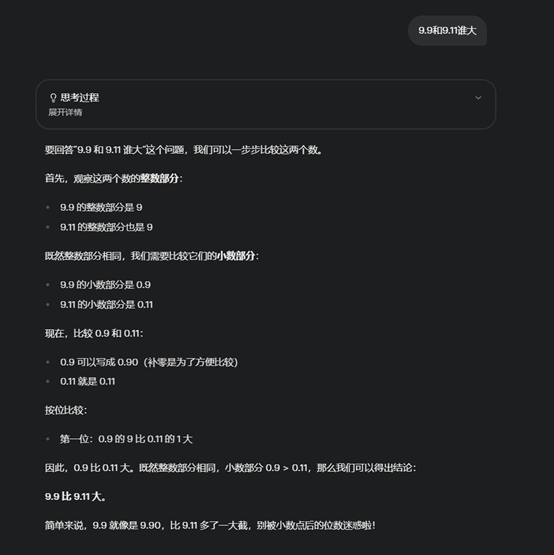

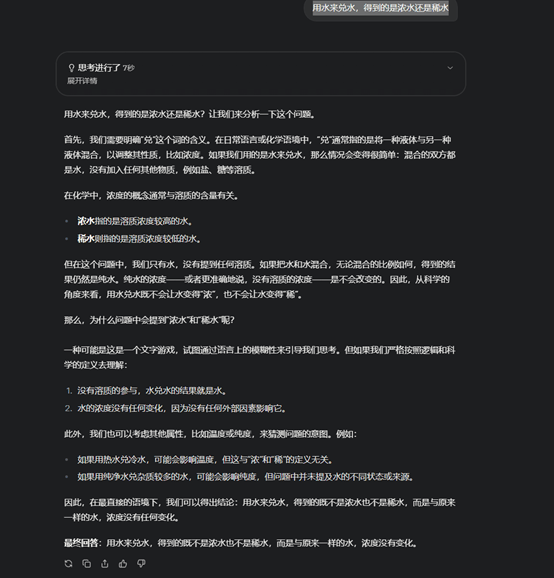

在基础问题的测试中,如“9.9和9.11谁大”,Grok 3轻松给出了正确答案。但在面对更为复杂的逻辑思考和文字理解挑战时,Grok 3的表现则略显波动。例如,在处理包含逻辑陷阱的“弱智吧”问题时,尽管Grok 3成功答对了部分题目,但在一道涉及因果推理的题目中却未能给出正确答案。相比之下,DeepSeek R1在此类问题上的表现更为出色。

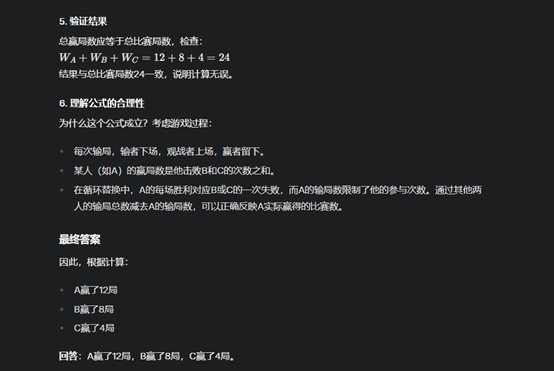

在数学能力的测试中,Grok 3展现出了其强大的实力。在一道复杂的台球对局问题中,Grok 3迅速给出了正确答案,且用时远少于OpenAI的o1。然而,在更为专业的群论问题中,尽管Grok 3答对了最终数量,但在具体群的识别上却出现了误差。这表明,尽管Grok 3在数学领域表现优异,但并未与其他同等级模型形成显著的差距。

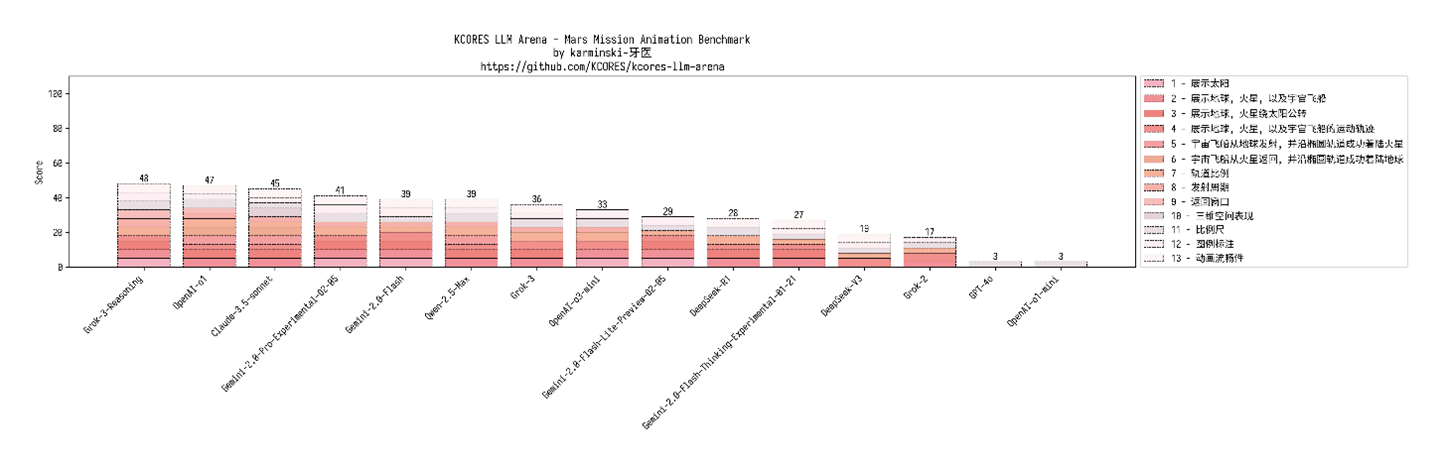

在编程能力的测试中,Grok 3同样展现出了不俗的实力。Kcores联合创始人karminski-牙医的测评结果显示,Grok 3在火星发射计划的代码模拟中表现优异,尽管在最终动画呈现上略有瑕疵,但整体轨道计算精确无误。在综合得分上,Grok 3位列第一,紧随其后的是OpenAI的o1,两者得分差距较小。

综合各项测试结果来看,Grok 3无疑是一款实力强劲的AI模型,其表现足以证明其20万张GPU的身价不菲。然而,在实际测试中,Grok 3并未像基准测试得分那样远远甩开对手,其最突出的优势在于极快的响应速度。至于马斯克所宣称的“地球上最聪明的人工智能”这一称号,或许还有待商榷。