百度创始人李彦宏在武汉举行的Create开发者大会上,向业界展示了百度在AI大模型领域的最新成果。在此次大会上,李彦宏宣布正式推出文心大模型4.5 Turbo与文心大模型X1 Turbo,两款新品旨在解决当前AI模型存在的多项挑战。

李彦宏在演讲中指出,尽管AI技术日新月异,但现有的部分模型,如DeepSeek,仍面临模态单一、幻觉率高、处理速度慢以及成本高昂等问题。百度此次推出的两款新模型,正是针对这些问题设计的解决方案。

他提到,随着DeepSeek的兴起,MCP(模型上下文协议)逐渐成为行业标准,同时,代码智能体和通用智能体等多智能体协作产品也受到广泛关注。然而,技术的快速发展也给开发者带来了困扰。许多开发者担心,随着模型的不断迭代和能力的增强,自己基于大模型开发的应用可能很快就会过时,失去价值。

李彦宏指出,AI大模型市场的竞争异常激烈,几乎每周都有新模型发布,每天都有更新。去年第四季度有49个大模型更新发布,而今年一季度更是达到了55个,最密集的时候一周内发布了8个模型。这种快速迭代让开发者无所适从,不敢放心大胆地开发应用。

他认为,对于开发者来说,当前既是机遇也是挑战。一方面,开发者需要紧跟技术发展趋势,避免陷入大模型自身发展的延长线;另一方面,日益强大的模型能力也为开发者提供了更多选择,关键在于找对场景、选对基础模型。

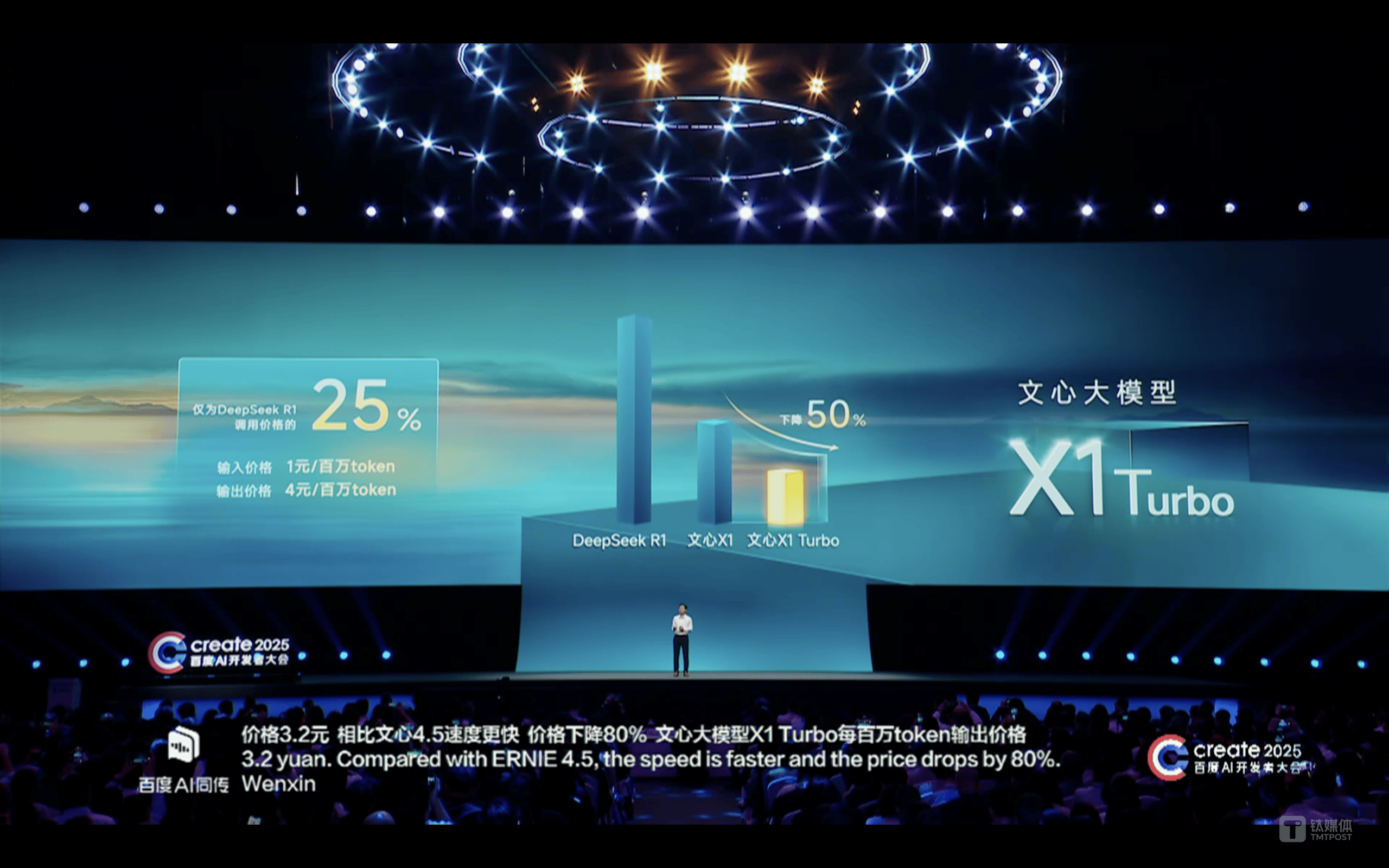

李彦宏强调,AI应用才是创造价值的真正所在。没有AI应用,模型和芯片都失去了实际价值。他提到,百度此次推出的文心大模型4.5 Turbo和文心大模型X1 Turbo,在速度和成本上都实现了显著提升。相比文心4.5,Turbo版速度更快,价格下降了80%,每百万tokens的输入价格仅为0.8元,输出价格为3.2元,仅为DeepSeek-V3的40%;而文心大模型X1 Turbo的价格更是仅为DeepSeek R1调用价格的25%,输入价格为1元/百万tokens,输出价格为4元/百万tokens。

百度还展示了基于昆仑芯三代P800的中国首个全自研的3万卡集群。李彦宏表示,该集群能够同时承载多个千亿参数大模型进行全量训练,并支持1000个客户进行百亿参数大模型的精调。

李彦宏在演讲的结尾表示,中国开发者在开发应用方面已经有了底气。他坚信,应用将创造未来,开发者也将创造未来。